近年来,数字经济发展速度之快、辐射范围之广、影响程度之深前所未有,隐私计算(Privacy-preserving computation)等新技术正在成为整合数据生产要素、促进数字经济发展、重塑全球经济结构的关键力量。

与此同时,新技术、新业态带来的数据安全隐患也为安全、产业发展和个人隐私带来诸多挑战。已于2021年9月1日起正式施行的《中华人民共和国数据安全法》(以下简称《数据安全法》),对新技术的发展提出了新要求,也指明了大数据产业健康发展的方向。

《数据安全法》对数据流通提出新要求

《数据安全法》提出要在保障数据安全的基础上促进数据的开发利用,一方面建立了数据安全保障制度的基本框架和数据处理者的基本义务,另一方面完善了数据产业发展、政务数据开放的促进机制。在保安全和促发展的大背景下,隐私计算技术有可能成为促进数据价值安全释放的关键技术手段。

隐私计算是指在保证数据提供方不泄露原始数据的前提下,对数据进行分析计算的一系列信息技术,保障数据在流通与融合过程中的“可用不可见”。隐私计算是众多技术交叉融合的产物,目前主流的隐私计算技术主要分为三大技术路线:条路线是以多方安全计算为代表的基于密码学的隐私计算技术;第二条路线是以联邦学习为代表的人工智能与密码学融合衍生的隐私计算技术;第三条路线是以可信执行环境为代表的基于可信环境的隐私保护技术。不同技术往往组合使用,在保证原始数据安全和隐私性的同时,完成对数据的计算和分析任务。

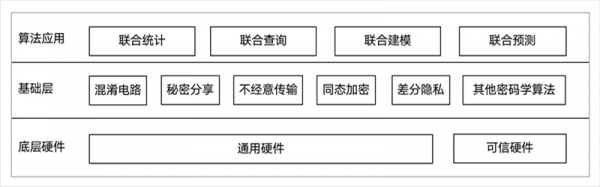

图1 隐私计算技术体系

隐私计算技术为数据的隐私保护与计算提供丰富的解决方案,可从底层硬件、基础层和算法应用等不同角度加以区分。隐私计算技术体系如图1所示。

在底层硬件层面,多方安全计算与联邦学习通常从软件层面设计安全框架,可信执行环境则是以可信硬件为底层技术而实现的隐私计算方案。

在算法构成层面,多方安全计算技术基于各类基础密码学工具设计不同的安全协议;联邦学习除可将多方安全计算协议作为其隐私保护的技术支撑外,基于噪声扰动的差分隐私技术也广泛应用于现在联邦学习框架中;可信执行环境通常与一些密码学算法、安全协议相结合,为多方数据提供保护隐私的安全计算。

以上述技术为基础,隐私计算逐渐演化出丰富的算法应用以满足不同场景需求。多方安全计算通常用于联合统计和查询场景;联邦学习则更侧重应用于联合建模及预测场景中;可信执行环境作为一种更加通用的技术方案,可设计用于联合统计、联合查询、联合建模及联合预测等诸多场景。

因此,隐私计算技术因其保障数据安全、挖掘数据价值的巨大潜力,有助于实现《数据安全法》在数据安全保障基础上促进数字经济发展的立法目的,促进数字技术与实体经济深度融合,保障安全以及个人、组织的合法权益。

隐私计算与《数据安全法》的适配分析

隐私计算通过在保护数据安全的同时实现多源数据跨域合作,有助于应对数据保护与融合应用的难题,有望成为平衡数据安全与应用发展的关键技术支点。

有助于履行安全保护义务

《数据安全法》第八条和第二十七条要求,开展数据处理活动应履行数据安全保护义务,采取相应的技术措施和其他必要措施,保障数据安全。隐私计算技术的整体特征是可以在不泄露原始数据的基础上,实现跨机构间数据的安全分析、安全计算、安全建模、安全预测、安全查询等,可在保护数据隐私的前提下为数据价值的挖掘提供安全保障。

以可信执行环境(Trusted Execution Environment,TEE)为例,TEE通过软硬件方法在中央处理器中构建一个安全的区域,保证其内部加载的程序和数据在机密性和完整性上得到保护。作为一个隔离的执行环境,TEE为在设备上运行的受信任应用程序提供了比普通操作系统更别的安全性以及比安全元件更多的功能。为了保证传输至可信环境中的数据的安全性,TEE也可以与其他密码学算法结合,有针对性地设计隐私计算方案。

因此,使用隐私计算技术助力数据流通本身即属于履行《数据安全法》要求的数据安全保护义务的一种形式。在实操中,当个人信息处理者需要自证合规时,隐私计算等技术有望作为履行信息安全保护义务的证据帮助企业减免违规风险。

有助于保障各主体数据权益

《数据安全法》第八条要求,开展数据处理活动,不得危害安全、公共利益,不得损害个人、组织的合法权益。以多方安全计算为例,在多个参与方共同计算一个目标函数时,该技术可以保证每一方仅获取自己的计算结果,无法通过计算过程中的交互数据推测出其他任意一方的输入和输出数据。由此,多个非互信主体得以在数据相互保密的前提下进行数据融合计算,实现对数据用途和用量的控制,有助于避免涉及安全、商业秘密、个人隐私的数据在融合过程中被其他方获知,因而隐私计算也是履行《数据安全法》权益保障义务的一种重要技术手段。

有助于促进数字经济产业生态建设

《数据安全法》章第十六条规定:“支持数据开发利用和数据安全技术研究,鼓励数据开发利用和数据安全等领域的技术推广和商业创新,培育、发展数据开发利用和数据安全产品、产业体系。” 在《数据安全法》为数字经济的监管定好基调和大方向的前提下,隐私计算作为合规数据互联互通的一种重要技术,将为数据交易、数据共享和政务数据开放等带来更大的发展空间和更广阔的应用前景。

对数据提供方而言,与传统直接通过数据集、数据接口等方式提供原始数据明文的方式相比,隐私计算以仅提供数据切片、模型梯度等衍生数据的方式,为数据流通提供了更安全、更合规的技术路径,丰富了数据流通的供给端;对数据需求方而言,不直接接触数据提供方的原始数据,只依照协议约定获取技术处理后的模型和输出结果,有助于明确数据需求方在数据流通过程中的角色,切分参与方之间的义务和责任,提高了数据利用效率和安全性;对隐私计算技术提供方而言,供需双方对安全和合规的迫切需求催生出巨大的市场空间,也为技术的跨跃式进步提供了更多可能。

隐私计算仍面临的问题

在隐私计算具备打破数据“孤岛”、加强隐私保护、强化数据安全合规性的潜力的同时,《数据安全法》等新法也对数据流通技术和产业提出了需要解决的新合规问题。

隐私计算无法避免数据源的违规隐患

作为对输入数据进行后续处理的一种技术,隐私计算技术本身不能解决数据来源的合规性问题。隐私计算是多元数据融合的过程,各参与方均可将自己收集到的数据投入联合机器学习及联合分析中,因此也导致了隐私计算的数据来源具有复杂性。数据源合规由此成为“牵一发而动全身”的问题,任何一个数据源受到污染均可能影响输出结果的质量。因此在将数据输入模型之前,隐私计算方案必须附加对数据来源合规性进行确认的流程和技术方案,避免影响隐私计算整体的安全与合规。

隐私计算需要保证过程数据和产出结果的合规

隐私计算输出的过程数据和最终计算结果也有涉及隐私的风险。例如在金融机构和征信机构合作预测某个借款人信用的场景,如果在特征对齐或输出预测结果时泄露了借款人的ID,则有可能泄露借款人本身有借款需求的信息。因此金融机构可能需要通过隐私集合求交集或隐私信息检索等方式,在预测借款人信用的同时不泄露借款人的ID,从而实现输出结果阶段的隐私保护。

隐私计算需要规避自动化决策的风险

当隐私计算模型的使用目的是实现信息推送、商业营销时,参与方也需要关注自动化决策的合规风险。例如当联邦学习被用于精准推荐的联合营销建模的场景时,根据现行法律的规定,隐私计算的参与方须保证决策的透明度和结果的公平公正,不得对个人在交易条件上实行不合理的差别待遇。换言之,隐私计算需要首先确保模型本身的设计符合算法正义的要求,算法具有一定的透明性和可解释性,由模型得出的结果不会对个人的权益造成不合理的影响。这对于具有一定黑盒属性的隐私计算而言,可谓是一个不小的挑战。

隐私计算参与方的定性存在模糊性

隐私计算的参与者众多,至少包括数据提供方、结果使用方、技术提供方3类角色。在实践中,参与方的职责和权利往往交叉融合,在隐私计算发展的早期,具体业务实践也往往因为缺乏共识而使得法律关系较为复杂。以使用隐私计算处理政务数据为例,作为技术提供方的隐私计算平台究竟如何在法律上定性,仍有多种可能性。技术提供方可能由于其对梯度数据等过程数据的处理而成为数据处理者,可能因为受数据供需方的委托处理数据而成为受托方,也可能因为促成了数据供需方的数据交换而构成《数据安全法》下的数据交易中介服务机构。

不同法律定性将影响隐私计算技术提供方需要承担的义务和责任。作为数据处理者,《数据安全法》要求其承担建立健全数据安全管理制度,加强风险监测及补救,采取技术措施保障数据安全和组织开展数据安全教育培训,采取相应的技术措施保障数据安全等义务;作为政务数据的受托方,《数据安全法》要求其依法依约履行数据安全保护义务,不得擅自留存、使用、泄露或者向他人提供政务数据;作为数据中介机构,技术提供方需要承担要求数据提供方说明数据来源、审核交易双方的身份、留存审核交易记录等义务。

隐私计算是一门多学科跨领域的综合技术体系,因此产业的发展需要监管机构、产业界和学术界的共同参与。通过建立各方之间的对话机制、充分发挥行业自律组织和标准化组织的作用,隐私计算产业将加速行业共识的形成和实践的沉淀,从而更敏捷地响应行业需求和监管的动向,为释放数据要素价值提供更有力的技术支撑。

(以上文章转载于网络,如有雷同或侵权,请联系IID工作人员处理,谢谢!)

QQ

QQ Telegram

Telegram Skype

Skype